반응형

※ 환경

Windows 10

Java version: 1.8.0_281

Python version: 3.8.5

RAM: 8.00GB

※ 설치

1. Apache Spark 다운로드

https://spark.apache.org/downloads.html

Downloads | Apache Spark

Download Apache Spark™ Choose a Spark release: Choose a package type: Download Spark: Verify this release using the and project release KEYS. Note that, Spark 2.x is pre-built with Scala 2.11 except version 2.4.2, which is pre-built with Scala 2.12. Spar

spark.apache.org

2. 압축 해제 후, C:/spark/에 위치

3. wintuils.exe File을 추가(https://github.com/cdarlint/winutils)

Hadoop이 Linux 기반에서 돌아가는 시스템이기 때문에, 호환하기 위해 프로그램 추가

C:/hadoop/bin에 파일 추가(없다면 디렉터리를 생성하고 추가)

4. 환경변수 설정

- SPARK_HOME 환경변수 추가

- HADOOP_HOME 환경변수 추가

- 기존 PATH에도 추가(%SPARK_HOME%\bin, %HADOOP_HOME%\bin)

5. cmd 창을 관리자 권한으로 열고, spark-shell 실행

or pyspark 실행

6. Test

rdd = spark.sparkContext.textFile('/labs/sample.txt')

rdd.collect()

7. Jupyter Notebook 연동

- 환경 변수 추가

PYSPARK_DRIVER_PYTHON = "jupyter"

PYSPARK_DRIVER_PYTHON_OPTS = "notebook"

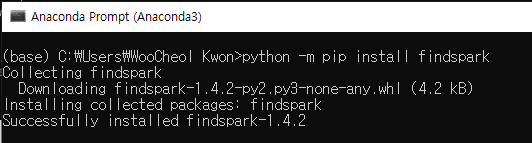

- Anaconda Prompt에서 아래와 같이 입력

$ python -m pip install findspark

반응형

'프로그래밍' 카테고리의 다른 글

| [pyspark] pyspark 프로그래밍 예제2 (0) | 2021.06.11 |

|---|---|

| [pyspark] pyspark 프로그래밍 예제 (0) | 2021.06.10 |

| [Spark] Ubuntu 20.04 Spark (0) | 2021.06.09 |

| [Sqoop] Ubuntu 20.04 Sqoop 활용(2) - 예시 (0) | 2021.06.08 |

| [Sqoop] Ubuntu 20.04 Sqoop 활용 (0) | 2021.06.07 |